NEWS

Adapter-Updates über die Weboberfläche ausgegraut ...

-

@ro75 hatte das mit "iob update" und "iob upgrade" einfach old shool über die Konsole gemacht ...

inzwischen auch iob stop, iob fix und iob start absolviert ...

-

@martinp nach iob start

host.iobroker-test-sicher 2024-09-16 13:45:39.502 error cannot get getHostInfo: Cannot read properties of undefined (reading 'speed') host.iobroker-test-sicher 2024-09-16 13:45:15.064 error Caught by controller[0]: [pidusage] We couldn't find uptime from /proc/uptime, using os.uptime() value -

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

uptime: Cannot get system uptime: Transport endpoint is not connected

Wenn ich mir die ganzen 'obskuren' Meldungen anschaue würde ich sagen, der Container rumpelt da irgendwie ein kleinwenig neben der Spur.

-

@thomas-braun Habe ihn gerade mal neu gestartet ...

Jetzt ist alles wieder ok...

-

-

Nach Quer gucken sieht das gut aus ... (bis auf die MQTT Adapter Probleme)

Skript v.2024-05-22 *** BASE SYSTEM *** Static hostname: iobroker-test-sicher Icon name: computer-container Chassis: container ☐ Virtualization: lxc Operating System: Debian GNU/Linux 12 (bookworm) Kernel: Linux 6.8.12-1-pve Architecture: x86-64 model name : Intel(R) Celeron(R) CPU N3000 @ 1.04GHz Docker : false Virtualization : lxc Kernel : x86_64 Userland : 64 bit Systemuptime and Load: 14:00:14 up 11 min, 2 users, load average: 50.09, 49.87, 49.65 CPU threads: 2 *** Time and Time Zones *** Local time: Mon 2024-09-16 14:00:14 CEST Universal time: Mon 2024-09-16 12:00:14 UTC RTC time: n/a Time zone: Europe/Berlin (CEST, +0200) System clock synchronized: yes NTP service: inactive RTC in local TZ: no *** Users and Groups *** User that called 'iob diag': martin HOME=/home/martin GROUPS=martin sudo iobroker User that is running 'js-controller': iobroker HOME=/home/iobroker GROUPS=iobroker tty dialout audio video plugdev *** Display-Server-Setup *** Display-Server: false Desktop: Terminal: Boot Target: graphical.target *** MEMORY *** total used free shared buff/cache available Mem: 6.4G 2.0G 3.7G 118K 808M 4.5G Swap: 6.4G 0B 6.4G Total: 12G 2.0G 10G Active iob-Instances: 23 6144 M total memory 1872 M used memory 2145 M active memory 394 M inactive memory 3500 M free memory 0 M buffer memory 771 M swap cache 6144 M total swap 0 M used swap 6144 M free swap *** top - Table Of Processes *** top - 14:00:14 up 11 min, 2 users, load average: 50.09, 49.87, 49.65 Tasks: 50 total, 1 running, 49 sleeping, 0 stopped, 0 zombie %Cpu(s): 25.0 us, 25.0 sy, 0.0 ni, 50.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st MiB Mem : 6144.0 total, 3498.8 free, 1874.1 used, 771.3 buff/cache MiB Swap: 6144.0 total, 6144.0 free, 0.0 used. 4269.9 avail Mem *** FAILED SERVICES *** UNIT LOAD ACTIVE SUB DESCRIPTION * run-rpc_pipefs.mount loaded failed failed RPC Pipe File System * sys-kernel-config.mount loaded failed failed Kernel Configuration File System * systemd-networkd-wait-online.service loaded failed failed Wait for Network to be Configured LOAD = Reflects whether the unit definition was properly loaded. ACTIVE = The high-level unit activation state, i.e. generalization of SUB. SUB = The low-level unit activation state, values depend on unit type. 3 loaded units listed. *** FILESYSTEM *** Filesystem Type Size Used Avail Use% Mounted on /dev/mapper/pve-vm--101--disk--0 ext4 63G 20G 40G 33% / none tmpfs 492K 4.0K 488K 1% /dev udev devtmpfs 3.8G 0 3.8G 0% /dev/tty tmpfs tmpfs 3.9G 0 3.9G 0% /dev/shm tmpfs tmpfs 1.6G 112K 1.6G 1% /run tmpfs tmpfs 5.0M 0 5.0M 0% /run/lock Messages concerning ext4 filesystem in dmesg: dmesg: read kernel buffer failed: Operation not permitted Show mounted filesystems: TARGET SOURCE FSTYPE OPTIONS / /dev/mapper/pve-vm--101--disk--0 ext4 rw,relatime,stripe=16 |-/run tmpfs tmpfs rw,nosuid,nodev,size=1595988k,nr_inodes=819200,mode=755,uid=100000,gid=100000,inode64 | |-/run/lock tmpfs tmpfs rw,nosuid,nodev,noexec,relatime,size=5120k,uid=100000,gid=100000,inode64 | |-/run/credentials/systemd-tmpfiles-setup-dev.service ramfs ramfs ro,nosuid,nodev,noexec,relatime,mode=700 | |-/run/credentials/systemd-tmpfiles-setup.service ramfs ramfs ro,nosuid,nodev,noexec,relatime,mode=700 | |-/run/credentials/systemd-sysctl.service ramfs ramfs ro,nosuid,nodev,noexec,relatime,mode=700 | `-/run/credentials/systemd-sysusers.service ramfs ramfs ro,nosuid,nodev,noexec,relatime,mode=700 |-/dev none tmpfs rw,relatime,size=492k,mode=755,uid=100000,gid=100000,inode64 | |-/dev/shm tmpfs tmpfs rw,nosuid,nodev,uid=100000,gid=100000,inode64 | |-/dev/mqueue mqueue mqueue rw,nosuid,nodev,noexec,relatime | |-/dev/.lxc/proc proc proc rw,relatime | |-/dev/.lxc/sys sys sysfs rw,relatime | |-/dev/full udev[/full] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/null udev[/null] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/random udev[/random] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/tty udev[/tty] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/urandom udev[/urandom] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/zero udev[/zero] devtmpfs rw,nosuid,relatime,size=3956668k,nr_inodes=989167,mode=755,inode64 | |-/dev/pts devpts devpts rw,nosuid,noexec,relatime,gid=100005,mode=620,ptmxmode=666,max=1026 | |-/dev/ptmx devpts[/ptmx] devpts rw,nosuid,noexec,relatime,gid=100005,mode=620,ptmxmode=666,max=1026 | |-/dev/console devpts[/0] devpts rw,nosuid,noexec,relatime,gid=100005,mode=620,ptmxmode=666,max=1026 | |-/dev/tty1 devpts[/1] devpts rw,nosuid,noexec,relatime,gid=100005,mode=620,ptmxmode=666,max=1026 | `-/dev/tty2 devpts[/2] devpts rw,nosuid,noexec,relatime,gid=100005,mode=620,ptmxmode=666,max=1026 |-/proc proc proc rw,nosuid,nodev,noexec,relatime | |-/proc/sys proc[/sys] proc ro,relatime | | |-/proc/sys/net proc[/sys/net] proc rw,nosuid,nodev,noexec,relatime | | `-/proc/sys/kernel/random/boot_id none[/.lxc-boot-id] tmpfs ro,nosuid,nodev,noexec,relatime,size=492k,mode=755,uid=100000,gid=100000,inode64 | |-/proc/sysrq-trigger proc[/sysrq-trigger] proc ro,relatime | |-/proc/cpuinfo lxcfs[/proc/cpuinfo] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/diskstats lxcfs[/proc/diskstats] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/loadavg lxcfs[/proc/loadavg] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/meminfo lxcfs[/proc/meminfo] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/slabinfo lxcfs[/proc/slabinfo] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/stat lxcfs[/proc/stat] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | |-/proc/swaps lxcfs[/proc/swaps] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other | `-/proc/uptime lxcfs[/proc/uptime] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other `-/sys sysfs sysfs ro,nosuid,nodev,noexec,relatime |-/sys/fs/fuse/connections fusectl fusectl rw,nosuid,nodev,noexec,relatime |-/sys/devices/virtual/net sysfs[/devices/virtual/net] sysfs rw,nosuid,nodev,noexec,relatime |-/sys/fs/cgroup none cgroup2 rw,nosuid,nodev,noexec,relatime `-/sys/devices/system/cpu lxcfs[/sys/devices/system/cpu] fuse.lxcfs rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other Files in neuralgic directories: /var: 3.9G /var/ 2.1G /var/lib 1.9G /var/lib/influxdb/engine/data/f11825691705bf53/autogen 1.9G /var/lib/influxdb/engine/data/f11825691705bf53 1.9G /var/lib/influxdb/engine/data Hint: You are currently not seeing messages from other users and the system. Users in groups 'adm', 'systemd-journal' can see all messages. Pass -q to turn off this notice. Archived and active journals take up 144.8M in the file system. /opt/iobroker/backups: 9.1G /opt/iobroker/backups/ /opt/iobroker/iobroker-data: 827M /opt/iobroker/iobroker-data/ 710M /opt/iobroker/iobroker-data/files 441M /opt/iobroker/iobroker-data/files/javascript.admin 409M /opt/iobroker/iobroker-data/files/javascript.admin/static 408M /opt/iobroker/iobroker-data/files/javascript.admin/static/js The five largest files in iobroker-data are: 24M /opt/iobroker/iobroker-data/files/web.admin/static/js/main.135279a0.js.map 19M /opt/iobroker/iobroker-data/files/vis-2/static/js/main.e7bb655f.js.map 19M /opt/iobroker/iobroker-data/files/vis-2/static/js/main.368dc292.js.map 19M /opt/iobroker/iobroker-data/files/vis-2/customWidgets.js.map 15M /opt/iobroker/iobroker-data/files/vis-2/static/js/376.1862d3de.chunk.js.map USB-Devices by-id: USB-Sticks - Avoid direct links to /dev/tty* in your adapter setups, please always prefer the links 'by-id': No Devices found 'by-id' *** NodeJS-Installation *** /usr/bin/nodejs v20.17.0 /usr/bin/node v20.17.0 /usr/bin/npm 10.8.2 /usr/bin/npx 10.8.2 /usr/bin/corepack 0.29.3 nodejs: Installed: 20.17.0-1nodesource1 Candidate: 20.17.0-1nodesource1 Version table: *** 20.17.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 100 /var/lib/dpkg/status 20.16.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.15.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.15.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.14.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.13.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.13.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.2-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.11.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.11.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.10.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.9.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.8.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.8.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.7.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.6.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.6.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.5.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.5.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.4.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.3.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.3.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.2.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.1.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.0.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 18.19.0+dfsg-6~deb12u2 500 500 http://ftp.debian.org/debian bookworm/main amd64 Packages 18.19.0+dfsg-6~deb12u1 500 500 http://security.debian.org bookworm-security/main amd64 Packages Temp directories causing npm8 problem: 0 No problems detected Errors in npm tree: *** ioBroker-Installation *** ioBroker Status iobroker is running on this host. Objects type: jsonl States type: jsonl Core adapters versions js-controller: 6.0.11 admin: 7.0.23 javascript: 8.7.6 nodejs modules from github: 0 Adapter State + system.adapter.admin.0 : admin : iobroker-test-sicher - enabled, port: 8081, bind: 0.0.0.0, run as: admin system.adapter.alias-manager.0 : alias-manager : iobroker-test-sicher - enabled + system.adapter.backitup.0 : backitup : iobroker-test-sicher - enabled + system.adapter.discovery.0 : discovery : iobroker-test-sicher - enabled + system.adapter.email.0 : email : iobroker-test-sicher - enabled system.adapter.fahrplan.0 : fahrplan : iobroker-test-sicher - disabled + system.adapter.fb-checkpresence.0 : fb-checkpresence : iobroker-test-sicher - enabled system.adapter.frigate.0 : frigate : iobroker-test-sicher - disabled + system.adapter.fritzdect.0 : fritzdect : iobroker-test-sicher - enabled system.adapter.ical.0 : ical : iobroker-test-sicher - enabled system.adapter.ical.1 : ical : iobroker-test-sicher - enabled + system.adapter.influxdb.0 : influxdb : iobroker-test-sicher - enabled, port: 8086 + system.adapter.javascript.0 : javascript : iobroker-test-sicher - enabled + system.adapter.javascript.1 : javascript : iobroker-test-sicher - enabled + system.adapter.meross.0 : meross : iobroker-test-sicher - enabled + system.adapter.mqtt-client.0 : mqtt-client : iobroker-test-sicher - enabled, port: 1888 system.adapter.mqtt-client.1 : mqtt-client : iobroker-test-sicher - disabled, port: 1883 + system.adapter.mqtt.0 : mqtt : iobroker-test-sicher - enabled, port: 1888, bind: 0.0.0.0 system.adapter.mqtt.1 : mqtt : iobroker-test-sicher - disabled, port: 1883, bind: 0.0.0.0 + system.adapter.operating-hours.0 : operating-hours : iobroker-test-sicher - enabled + system.adapter.ping.0 : ping : iobroker-test-sicher - enabled + system.adapter.reolink.0 : reolink : iobroker-test-sicher - enabled + system.adapter.reolink.1 : reolink : iobroker-test-sicher - enabled + system.adapter.simple-api.0 : simple-api : iobroker-test-sicher - enabled, port: 8087, bind: 0.0.0.0, run as: admin + system.adapter.snmp.0 : snmp : iobroker-test-sicher - enabled + system.adapter.sonoff.0 : sonoff : iobroker-test-sicher - enabled, port: 1892, bind: 0.0.0.0 + system.adapter.tradfri.0 : tradfri : iobroker-test-sicher - enabled + system.adapter.vis-2.0 : vis-2 : iobroker-test-sicher - enabled system.adapter.vis.0 : vis : iobroker-test-sicher - enabled + system.adapter.web.0 : web : iobroker-test-sicher - enabled, port: 8082, bind: 0.0.0.0, run as: admin + instance is alive Enabled adapters with bindings + system.adapter.admin.0 : admin : iobroker-test-sicher - enabled, port: 8081, bind: 0.0.0.0, run as: admin + system.adapter.influxdb.0 : influxdb : iobroker-test-sicher - enabled, port: 8086 + system.adapter.mqtt-client.0 : mqtt-client : iobroker-test-sicher - enabled, port: 1888 + system.adapter.mqtt.0 : mqtt : iobroker-test-sicher - enabled, port: 1888, bind: 0.0.0.0 + system.adapter.simple-api.0 : simple-api : iobroker-test-sicher - enabled, port: 8087, bind: 0.0.0.0, run as: admin + system.adapter.sonoff.0 : sonoff : iobroker-test-sicher - enabled, port: 1892, bind: 0.0.0.0 + system.adapter.web.0 : web : iobroker-test-sicher - enabled, port: 8082, bind: 0.0.0.0, run as: admin ioBroker-Repositories ┌─────────┬──────────┬─────────────────────────────────────────────────────────┬──────────────┐ │ (index) │ name │ url │ auto upgrade │ ├─────────┼──────────┼─────────────────────────────────────────────────────────┼──────────────┤ │ 0 │ 'stable' │ 'http://download.iobroker.net/sources-dist.json' │ false │ │ 1 │ 'beta' │ 'http://download.iobroker.net/sources-dist-latest.json' │ false │ └─────────┴──────────┴─────────────────────────────────────────────────────────┴──────────────┘ Active repo(s): stable Upgrade policy: none Installed ioBroker-Instances Used repository: stable Adapter "admin" : 7.0.23 , installed 7.0.23 Adapter "alias-manager": 1.2.6 , installed 1.2.6 Adapter "backitup" : 3.0.22 , installed 3.0.22 Adapter "benchmark" : 1.3.0 , installed 1.3.0 Adapter "deconz" : 1.4.1 , installed 1.4.1 Adapter "discovery" : 4.5.0 , installed 4.5.0 Adapter "email" : 1.3.1 , installed 1.3.1 Adapter "fahrplan" : 1.2.3 , installed 1.2.3 Adapter "fb-checkpresence": 1.2.4 , installed 1.2.4 Adapter "frigate" : 1.2.0 , installed 1.2.1 Adapter "fritzdect" : 2.5.11 , installed 2.5.11 Adapter "ical" : 1.15.0 , installed 1.15.0 Adapter "influxdb" : 4.0.2 , installed 4.0.2 Adapter "jarvis" : 3.1.8 , installed 3.1.8 Adapter "javascript" : 8.7.6 , installed 8.7.6 Controller "js-controller": 6.0.11 , installed 6.0.11 Adapter "meross" : 1.17.0 , installed 1.17.0 Adapter "mqtt" : 5.2.0 , installed 5.2.0 Adapter "mqtt-client" : 2.0.0 , installed 2.0.0 Adapter "operating-hours": 1.1.0 , installed 1.1.0 Adapter "ping" : 1.6.2 , installed 1.6.2 Adapter "reolink" : 1.1.1 , installed 1.1.1 Adapter "simple-api" : 2.8.0 , installed 2.8.0 Adapter "smartmeter" : 3.4.0 , installed 3.4.0 Adapter "snmp" : 3.2.0 , installed 3.2.0 Adapter "socketio" : 6.7.1 , installed 6.7.1 Adapter "sonoff" : 3.1.0 , installed 3.1.0 Adapter "tr-064" : 4.3.0 , installed 4.3.0 Adapter "tradfri" : 3.1.3 , installed 3.1.3 Adapter "vis" : 1.5.6 , installed 1.5.6 Adapter "vis-2" : 2.9.32 , installed 2.9.32 Adapter "web" : 6.2.5 , installed 6.2.5 Adapter "ws" : 2.6.2 , installed 2.6.2 Adapter "zigbee2mqtt" : 2.13.6 , installed 2.13.6 Objects and States Please stand by - This may take a while Objects: 2779 States: 2351 *** OS-Repositories and Updates *** Hit:1 http://ftp.debian.org/debian bookworm InRelease Hit:2 http://ftp.debian.org/debian bookworm-updates InRelease Hit:3 http://security.debian.org bookworm-security InRelease Hit:4 https://repos.influxdata.com/debian stable InRelease Hit:5 https://apt.grafana.com stable InRelease Hit:6 https://deb.nodesource.com/node_20.x nodistro InRelease Reading package lists... Pending Updates: 0 *** Listening Ports *** Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State User Inode PID/Program name tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 0 108794370 1/init tcp 0 0 0.0.0.0:1892 0.0.0.0:* LISTEN 1001 108813845 525/io.sonoff.0 tcp 0 0 0.0.0.0:1888 0.0.0.0:* LISTEN 1001 108812050 498/io.mqtt.0 tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 0 108803046 348/master tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1001 108805140 368/iobroker.js-con tcp 0 0 127.0.0.1:9001 0.0.0.0:* LISTEN 1001 108805058 368/iobroker.js-con tcp6 0 0 :::111 :::* LISTEN 0 108794372 1/init tcp6 0 0 :::22 :::* LISTEN 0 108794682 1/init tcp6 0 0 ::1:25 :::* LISTEN 0 108803047 348/master tcp6 0 0 :::3000 :::* LISTEN 109 108804726 367/grafana tcp6 0 0 :::8087 :::* LISTEN 1001 108816478 687/io.simple-api.0 tcp6 0 0 :::8086 :::* LISTEN 998 108803748 172/influxd tcp6 0 0 :::8081 :::* LISTEN 1001 108805796 417/io.admin.0 tcp6 0 0 :::8082 :::* LISTEN 1001 108816757 669/io.web.0 udp 0 0 0.0.0.0:46184 0.0.0.0:* 1001 108815704 676/io.tradfri.0 udp 0 0 0.0.0.0:40879 0.0.0.0:* 1001 108815883 587/io.snmp.0 udp 0 0 0.0.0.0:111 0.0.0.0:* 0 108794371 1/init udp6 0 0 :::111 :::* 0 108794373 1/init *** Log File - Last 25 Lines *** 2024-09-16 13:59:42.757 - info: admin.0 (417) ==> Connected system.user.admin from ::ffff:192.168.2.115 2024-09-16 13:59:45.755 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 4 deleted after 12 retries 2024-09-16 13:59:45.755 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 3 deleted after 12 retries 2024-09-16 14:00:00.074 - info: host.iobroker-test-sicher instance system.adapter.ical.0 in version "1.15.0" started with pid 1500 2024-09-16 14:00:00.226 - info: javascript.0 (455) script.js.Energiezaehler.Gaszaehler: Actual Pulses 137474 Last Pulses 137469 =0.557 2024-09-16 14:00:06.909 - info: ical.0 (1500) starting. Version 1.15.0 in /opt/iobroker/node_modules/iobroker.ical, node: v20.17.0, js-controller: 6.0.11 2024-09-16 14:00:09.415 - info: ical.0 (1500) processing URL: Martin_docker http://192.168.2.146:5232/martin/e4c584bc-2ea6-bae6-1d4e-debe6a702f21/ 2024-09-16 14:00:09.776 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:00:14.925 - info: ical.0 (1500) Terminated (NO_ERROR): Without reason 2024-09-16 14:00:15.529 - info: host.iobroker-test-sicher instance system.adapter.ical.0 having pid 1500 terminated with code 0 (NO_ERROR) 2024-09-16 14:00:15.781 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:00:17.792 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:00:19.783 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:00:21.782 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:00:22.567 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] connection closed: closed 2024-09-16 14:00:31.955 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] connected with secret 1726488031944_3480 2024-09-16 14:00:31.974 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] Received pubrec on esp32-e0624b304ec0 for unknown messageId 1 2024-09-16 14:00:59.831 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:01:05.833 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:01:09.833 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:01:11.835 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:01:11.836 - warn: mqtt.0 (498) Client [esp32-e0624b304ec0] Message 5 deleted after 11 retries 2024-09-16 14:01:12.577 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] connection closed: closed 2024-09-16 14:01:21.946 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] connected with secret 1726488081946_210 2024-09-16 14:01:21.953 - info: mqtt.0 (498) Client [esp32-e0624b304ec0] Received pubrec on esp32-e0624b304ec0 for unknown messageId 1 -

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

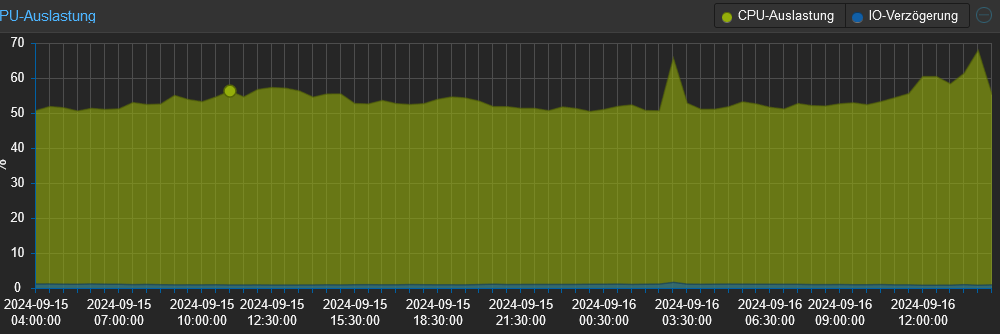

14:00:14 up 11 min, 2 users, load average: 50.09, 49.87, 49.65

wirklich?

Ro75.

-

@ro75 Ist ein LXC-Container, habe nicht PVE rebootet, sondern nur den Container über die PVE Weboberfläche.... die Weboberfläche von iob war jedenfalls nicht erreichbar

EDIT ich sehe da 11 Minuten uptime ...

14:10:46 up 22 min, 1 user, load average: 47.30, 48.30, 49.00Der erste Wert ist wohl die aktuelle Uhrzeit

-

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

load average: 47.30, 48.30, 49.00

Da geht es eher drum. Wobei so eine Load auf 'Haushaltsware' auch eher unrealistisch ist.

-

@thomas-braun Ist eine ziemlich lahme Kiste, ein Celeron N3000 spielt etwa in der Liga eines Pi4 ...

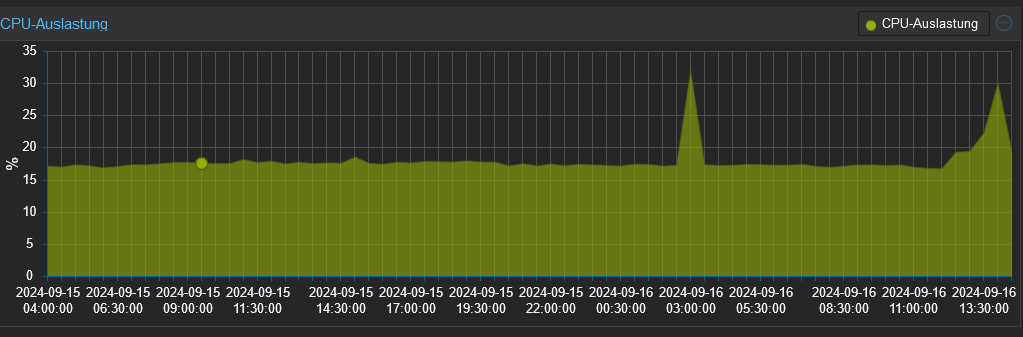

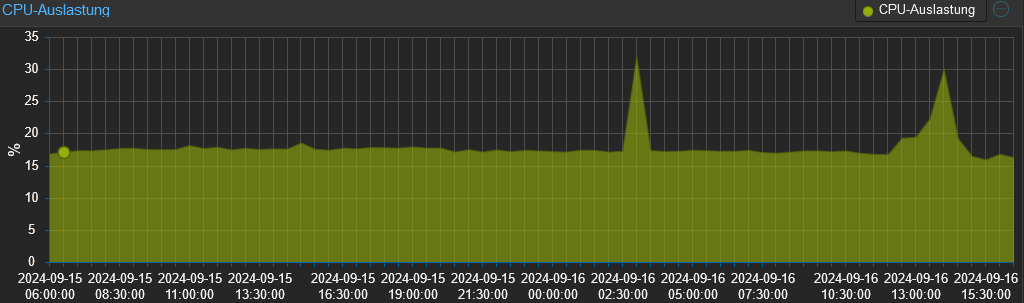

Proxmox selber zeigt etwas niedrigere "Fieberkurven" für den LXC-Container

Kann es sein, dass bei einem LXC-Container da falsch angezeigt wird - das wird im PVE selber angezeigt:

EDIT: Das sind die gehosteten VMs / LXC

-

Schade, die Zigbee2mqtt VM scheint das Zeitliche gesegnet zu haben - sieht gestartet aus, ist aber per IP nicht erreichbar...

-

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

Proxmox selber zeigt etwas niedrigere "Fieberkurven" für den LXC-Container

naja, über 2 oder 4 (je nach CPU) sollte der Wert nicht liegen

-

@homoran said in Adapter-Updates über die Weboberfläche ausgegraut ...:

naja, über 2 oder 4 (je nach CPU) sollte der Wert nicht liegen

Sind das keine Prozentwerte?

Der Celeron N3000 hat eben je nach Benchmark nur etwa 1/5 ... 1/10 der Performance eines Intel N100 ...

da werden aus 2...4 auf dem N100 eben 10...40%....

Der LXC-Container selber scheint sich auch die prognostizierten 10 ... 40% zu gönnen

-

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

Sind das keine Prozentwerte?

Normalerweise nicht.

die load average ist nicht %CPUBei der load average sollte der Wert nicht die Anzahl der Kerne überschreiten.

Ab da ist Abarbeitungsrückstau.EDIT: Was du da zeigst ist tatsächlich %CPU!

iob diagzeigt aber die load average der letzten, der letzten 5 und der letzten 15 Minuten an -

@homoran Ja, der Wert ist SEHR hoch ....

https://wiki.ubuntuusers.de/uptime/

Zwei Kerne -> nicht viel höher als 2 wäre das Ziel ...

Vielleicht schlage ich dann doch mal zu, wenn irgendwann ein Hardware "Schnapper" vor die Flinte kommt ...

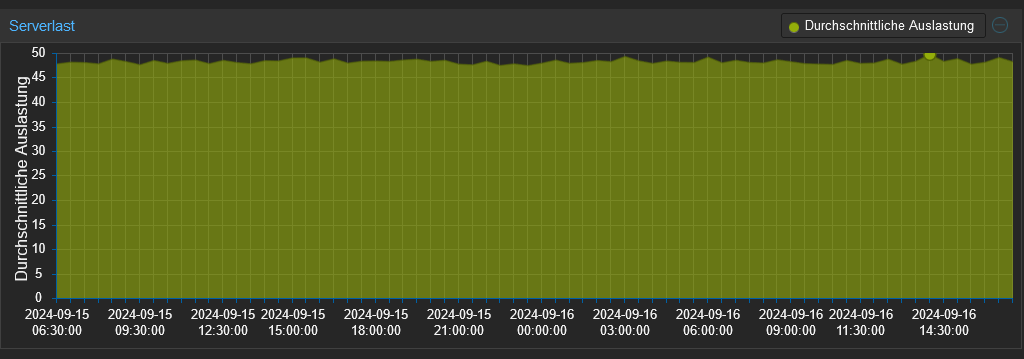

Entweder ein gebrauchter sparsamer i5 oder ein N100 ...Das ist aus dem PVE Hauptfenster und DEFINITIV dieser "Load Avg." Wert und keine Prozente... dauerhaft auf 45 ...50 ...

-

@martinp sagte in Adapter-Updates über die Weboberfläche ausgegraut ...:

Das ist aus dem PVE Hauptfenster und DEFINITIV dieser "Load Avg." Wert und keine Prozente... dauerhaft auf 45 ...50 ...

ich tippe da aber auf eine Fehlanzeige/Softwareproblem.

Bei 2 Kernen würdest du wahrscheinlich bei einer Load von 5 schon nicht mehr auf den Server kommen. -

Würde ich auch vermuten...

Die Wuppdizität der iobroker Oberfläche und der VIS-Fenster ist sicherlich nicht die beste, aber ich sitze beruflich sehr viel auf Rechnern per remote Session, und bin das eigentlich gewöhnt

Meinem Spieltrieb werde ich aber ggfs trotzdem Einhalt gebieten - keine weiteren LXC-Container auf die arme Kiste

-

Noch ein wenig Lesefutter

https://www.suse.com/support/kb/doc/?id=000016923

The vmstat command's "r" column under "procs" shows the current number of processes waiting to get on the run queue at a given instant in time. The uptime command shows the average number of processes on the run queue and waiting to get on the run queue in the last one, five and fifteen minutes. In the example above, the load averages indicate the server is getting busier, because the average processes in the last minute is higher than the fifteen minute average.

root@pve:~# vmstat 1 4 procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 4 0 2030592 837036 907484 2304212 3 3 114 151 2022 2108 25 20 51 1 0 1 0 2030592 837036 907484 2304212 0 0 768 88 3643 3739 31 41 28 1 0 1 0 2030592 837036 907484 2304212 0 0 0 140 2910 2883 16 13 71 1 0 2 0 2030592 837036 907484 2304212 0 0 0 288 3291 3201 19 23 57 2 0Hier noch zum Vergleich die Werte vom Linux Mint PC mit Cinnamon Desktop ...

martin@martin-D2836-S1:~$ uptime 19:36:58 up 10 days, 10:23, 1 user, load average: 0,61, 0,15, 0,05 martin@martin-D2836-S1:~$ vmstat 1 4 Prozesse -----------Speicher---------- ---Auslagerung-- -----E/A---- -System-- ------CPU----- r b swpd frei buff Cache si so bi bo in cs US SY ID WA st 0 0 1981436 730472 1574332 1412080 0 1 23 27 2 4 1 1 98 0 0 0 0 1981436 730724 1574332 1412140 0 0 0 0 2377 4077 2 1 98 0 0 0 0 1981436 730724 1574332 1412140 0 0 0 0 3073 5397 1 1 99 0 0 1 0 1981436 730724 1574332 1412140 0 0 0 0 2337 3928 2 1 98 0 0 martin@martin-D2836-S1:~$