NEWS

Speech2ioBroker

-

Wow!

Das ist genau das, was ich schon längst schreiben wollte.

Nun wollte ich einen Adapter daraus machen.

Dein Skript wird definitiv als Basis benutzt.

Ich wollte das Skript nicht nur für Speech benutzen, sondern auch als Chat bot. Z.b Telegramm oder Skype oder email, pushbullet.

Will nur denn (irgendwann ) erweitern, dass auch Antwort gesendet wird und auch ob bei dem passenden Regel angehalten werden muss oder weiter gesucht. `

Ein einfach zu konfigurierender Adapter wäre prima, leider kenne ich mit dem Admin Interface so gar nicht aus

.

.Woher die Eingabe kommt, also ob Sprache oder Textchat, ist dem Skript egal. Man kann damit natürlich auch einfach einen State für Email usw. überwachen.

Das Skript wertet alle Regeln aus, die auf den Input zutreffen, nicht nur die erste. Um falsche Regelerkennung auszuschließen kann man die Keyword-Blacklist nutzen, das klappt bei mir ganz gut. Manchmal kann es natürlich auch gewollt sein, dass mehrere Regeln aktiv werden.

Als Antwort kann man in beliebige States schreiben oder aber auch ein Skript eingeben, welches ggf. direkt eine Email sendet.

Die eigentliche Arbeit im Skript passiert in wenigen Zeilen Code, der Erfolg hängt natürlich stark von den Patterns und Rules ab, wobei ich mit denen im Skript wirklich sehr frei formulierte Sätze in den richtigen Befehl umwandeln kann, wichtig ist nur, dass im Satz der Ort ("Wohnzimmer"), das Objekt ("Licht") und der Befehl ("an"/"aus"/"xx%") vorkommt.

Wichtig ist auch, dass man die Patterns gut definiert. In der Deutschen Sprache gibt es viele Wortzusammensetzungen, daher habe ich immer definiert, ob ein Pattern am Wortanfang, Wortende oder ganz alleine stehen muss. Am einfachsten ist das Verbessern der Pattern aber, wenn man einen Satz gefunden hat, der falsch erkannt wird, oder einen der nicht richtig erkannt wird. Dann kann man die Patterns relativ einfach anpassen.

-

Hallo Pman,

ich hab dein Skript ausprobiert und bin begeistert! Super Arbeit!

Mit einigen Anpassungen hat es gleich geklappt, die Aussentemperatur abzufragen und den Dimmer im WC zu bedienen. Natürlich braucht es für die ganze Wohnung einiges an Anpassungen, aber der scenes-Adapter spielt da ja sehr gut rein. Die andere Seite der Ausgabe wird super vom Sayit-Adapter bedient. Ist ja schließlich kein Problem die response Variable mit der Sayit.text zu synchronisieren und ggf. noch eine Funktion zur Prüfung der Aussprache einzubauen (aus Punkt wird Komma, aus ° wird Grad, etc.).

Mir bereitet allerdings noch die Eingabe-Seite Kopfzerbrechen. Ich will ja meine Kommandos nicht eintippen :lol: und es kommt nur eine offline-Spracherkennung ins Haus. Ich habe mir http://jasperproject.github.io mal angesehen. Das läuft auf einem Pi und hat eine API. Was hast du im Kopf?

Nochmal: Tolle Arbeit!

Gruß,

Pix

-

Das liest sich sehr gut, was du da gebaut hast. Kann man denn auch schon deine Android App testen?

Momentan nutze ich das alles noch über den Umweg mit Tasker, geht auch, aber ein Adapter mit dazugehöriger App wäre natürlich wesentlich genialer

-

@pix:Mir bereitet allerdings noch die Eingabe-Seite Kopfzerbrechen. Ich will ja meine Kommandos nicht eintippen :lol: und es kommt nur eine offline-Spracherkennung ins Haus. Ich habe mir http://jasperproject.github.io mal angesehen. Das läuft auf einem Pi und hat eine API. Was hast du im Kopf? `

Ich nutze die Spracherkennung von Android, diese funktioniert auch offline. Vorteil ist, dass man nichts konfigurieren muss und die Spracherkennung auch bei schwierigen akustischen Situationen sehr gut funktioniert. Ab dem SDK für Android 6.0 kann man sogar offline Erkennung erzwingen, vorher wird diese nur genutzt wenn das Gerät nicht Online ist.Ich habe vor mir ein Wandtablet zu bauen, worauf die Android App laufen soll. Perfekt wäre das in Kombination mit einem Bluetooth Headset bzw. nur Mikrofon, da habe ich aber noch nichts passendes gefunden.

Das liest sich sehr gut, was du da gebaut hast. Kann man denn auch schon deine Android App testen?

Momentan nutze ich das alles noch über den Umweg mit Tasker, geht auch, aber ein Adapter mit dazugehöriger App wäre natürlich wesentlich genialer

`

`

Die App wird noch entwickelt, nutzbar noch nicht wirklich. Vor allem weil ein ioBroker Adapter oder Skript fehlt, welches die nötigen States automatisiert anlegt. Die States habe ich bei mir manuell in Admin angelegt. Ein wenig mehr dazu hier: -

Hallo alle

Ich wollte auch mal experimentieren und habe da Script im IBroker unter Sripts reinkopiert.

Und wie gehts jetzt weiter?

Müsste ich jetzt nicht unter Zustände ein javascript.0.speech2ioBroker.text Objekt finden in das ich "Wohnzimmer Licht an" schreiben kann?

Hab ich aber nicht. Nur unter Objekte gib es die.

Gruss Ralf

-

Hallo,

der Thread ist genau ein Jahr alt, was nicht heisst, dass das SKript nicht funktioniert.

Es gibt mittlerweile den text2command - Adapter.

Gruß

Pix

-

Hi Pix

Text2command finde ich nicht unter den angeboteen Adaptern

Sollte der nicht unter "Scripte und Logik" auftauchen? Ich habe die Adapterinfomationen aktualisiert, aber der kommt nicht…

Gruss Ralf

-

Hallo ralf,

@derrapf:Text2command finde ich nicht unter den angeboteen Adaptern

Sollte der nicht unter "Scripte und Logik" auftauchen? `

Genau da:

sonst mach es mal wie ich und such mit Strg-F

Gruß

RAiner

-

Hallo Rainer

Schon gemacht. Da is nix. Bei Dir ist es übrigens auch unter "Scripte und Logik".

Ich hab da nur die ersten drei.

Gruss Ralf

-

Hallo Rainer

Schon gemacht. Da is nix. Bei Dir ist es übrigens auch unter "Scripte und Logik".

Ich hab da nur die ersten drei.

Gruss Ralf `

Was für eine Repository verwendest du? -

Äh…keine Ahnung. Was ist das? Wo steht das? Wie finde ich es raus?

Gruss Ralf

-

System-Einstellungen - ganz rechts oben das Zahnrad

Dann unter Haupteinstellungen der aktive Verwahrungsort

den dort ausgewählten bitte auf dem nächsten Reiter "Verwahrungsorte" nachschlagen und den Pfad hier posten.

Gruß

Rainer

-

Ok. Danke.

Das sieht bei mir dann so aus:

default conf/sources-dist.json online https://raw.githubusercontent.com/ioBroker/ioBroker.js-controller/master/conf/sources-dist.jsonGruss Ralf

-

Und welche davon ist in den Haupteinstellungen ausgewählt?

Wie alt ist dein admin?

Stell auf jeden Fall mal auf online und mach einen refresh unter "Adapter "

Gruß

Rainer

-

Hallo Rainer

Das wars!

Nachdem ich von default auf online gestellt hatte und neu refreshed hatte, war's da.

Jetzt teste ich ein bischen am Wochenende.

Der Admin und Vis usw. ist übrigens leider ziemlich alt; aber das liegt daran, dass ich nicht updaten kann.

Jedesmal wenn ich VIS oder den Admin update, zerreist es den Iobroker. Das liegt wohl an der alten note.js Version.

Ich habe es aber auch noch nicht hinbekommen ibroker auf dem Bananapi mit Jessie zum laufen zu bringen.

Ich bekomme schon initial kein Note.js drauf. Ich hab mich vor knapp einem Jahr mal Wochen damit beschäftigt (Du warst glab ich auch in dem thread beteiligt) und hab dann aber aufgegeben.

Gruss Ralf

-

Hab jetzt doch noch rumgespielt. Irgend was stimmt nicht. Nach der Installation wollte ich wie üblich den Adapter konfigurieren:

Die Anleitung unter http://www.iobroker.net/docu/?page_id=4711&lang=en kann ich aber auch nicht nachvollziehen, denn ich habe z.B. nicht den angesprochenen Tab-Reiter "Adapter configuration". Die Screenshots sehen auch ganz anders aus wie bei mir (weil ich noch eine alte Version habe?)Ui und das sieht auch nicht gesund aus:

Gruss Ralf -

Hi Ihr, Ich weiss das ist ein Alter Post, aber ich finde Ihn Ideal.

OK, Ich bin anfänger und ein bisschen voll im Kopf mit dem Input der Installation und einrichtung, (inkl. fehler behebung ) Ich bin also fragebedürftig.

Was möchte Ich: am liebsten in mein micro am Pi und Patop Handy ect reden und verstanden werden ( Also nicht wie meine Frau ^^ ) Also ohne eine Taste zu drücken. wie lich an, und es geht an.

Dose Ist Installiert, eingetragen und lässt sich brav über vis steuern.

Die überschrift bedeutet "speech2ioBroker"

im text liest man nun "text2command"

wobei ich nicht erkennen kann wo der zusammenhang sein soll.

habe es zwar installiert, und reagiert auch, aber ich rede ja und übertrage keine geschriebenen worte aus meinen Mund ^^

( glaube ich wenigstens nicht ^^ )

Wie habt ihr das in den Begriff bekommen ?

Lg

p.s. kein Alexa bitte ^^, kenne auch andere namen wie alexa ^^

-

Hi

Speech2iobroker war mal ein Script das aber inzwischen überholt ist und durch text2command ersetzt wurde.

text2command bietet die Mögichkeit text den Du in den Datenpunkt text2command.0.text reinschreibst in Befehle umzuwandeln.

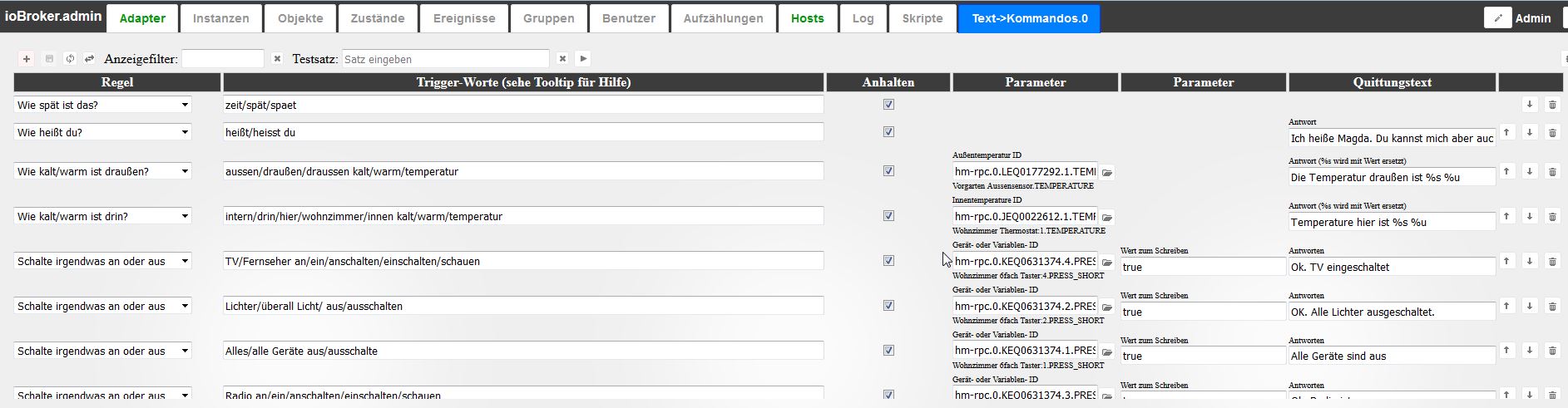

Daszu musst Du in der Konfiguratinsoberfläche von text2command entsprechende keywords einrichten worauf er reagieren soll. Beispiel:

Wie kommt der Text in die Variable?-

Entweder Du schreibst ihn manuell rein (Macht nur zu Testen Sinn)

-

Du schreibst ein Script das ihn da reinschreibt

-

Du (und das ist was Du willst) baust das Widget mit dem Namen "Speech to Text" in Deine VIS-View ein. Das Widget hört ständig zu, versucht zu erkennen was Du sagt und schreibt das dann in text2command.0.text.

Gruss Ralf

-

-

Den oberen Teil hatte ich schon und geht auch, aber wie stell ich das widget ein ?

EDIT::: hat sich erledigt. hatte den Adapter falsch eingetragen, Jetzt gehts

Danke

-

Den oberen Teil hatte ich schon und geht auch, aber wie stell ich das widget ein ?

EDIT::: hat sich erledigt. hatte den Adapter falsch eingetragen, Jetzt gehts

Danke `

Hi,

kannst du mir verraten was in das Widget rein muss und welches Micro verwendest? Tablet oder ein extra angeschlossenes?

Und dann noch ne Frage an alle, wo oder wie komme ich an die Ausgabe? Wenn ich zum Beispiel nach der Temperatur frage, wird die dann angesagt oder nur angezeigt?

Danke und schönen Abend

Mirko