NEWS

iobroker hochverfügbar

-

@apollon77 sagte in iobroker hochverfügbar:

jeder nuc kann ggf seine 1gb voll ausnutze

Ok. Müsste mal schauen was meine Unifi Switchtes auf der Backplane liefern - sollte aber mehr als 1Gb sein. Die Dream Machine Pro ist allerdings beschnitten auf 1Gb.

@apollon77 sagte in iobroker hochverfügbar:

Am Ende wenn du pro Host einen glusterfs brick hast ist das alles noch easy. Meine bricks sind anders verteilt und daher mehr und da wird es ggf eng wenn die mal alle Daten syncen wollen

Ich versuche mich mal dran, komme sicher mit der ein oder anderen Frage auf dich zurück

-

-

@paul53 sagte in iobroker hochverfügbar:

@homoran sagte: da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

Bis auf das Rekeying über das Internet, was mich stören würde

stimmt! das dauert etwas.

hatte ich nicht auf dem Schirm -

@homoran sagte: das dauert etwas.

Das wäre nicht so schlimm, aber ein hochverfügbares System sollte nicht vom Internet abhängig sein.

-

@darkiop wenn alles am gleichen Switch hängt ist ja erstmal easy mit Netzwerk. Die backplane hat meistens ne viel höhere Leistung. Dann user nur dein Switch halt auch ein SPOF

-

@paul53 sagte in iobroker hochverfügbar:

Was nutzt die Hochverfügbarkeit von ioBroker, wenn wichtige Geräte nicht mehr gesteuert werden können?

Das ist Salamitaktik, wie beim Testen. Wenn vollständig nicht geht, dann macht man das was geht. Besser als nicht starten.

Leider gibt es tatsächlich Quertreiber wie Zigbee, wo der Koordinator seine Schäfchen an sich bindet und ein Ersatz nicht vorgesehen ist.

Aber mit einem redundanten ioBroker hätte man zumindest Funktion während der Updates. Seit bei mir das gesamte Wohnungslicht über Zigbee und ioBroker läuft, bin ich da (noch) sensibler geworden.Aber zumindest habe ich bisher die Abhängigkeiten von USB für die Interfaces eliminiert. Smartmeter, RFLink und Zigbee laufen über TCP und können daher von verschiedenen Rechnern aus parallel angesprochen werden.

-

@apollon77 sagte in iobroker hochverfügbar:

@darkiop wenn alles am gleichen Switch hängt ist ja erstmal easy mit Netzwerk. Die backplane hat meistens ne viel höhere Leistung. Dann user nur dein Switch halt auch ein SPOF

Ja - das ist klar - aber das Risiko gehe ich erstmal ein.

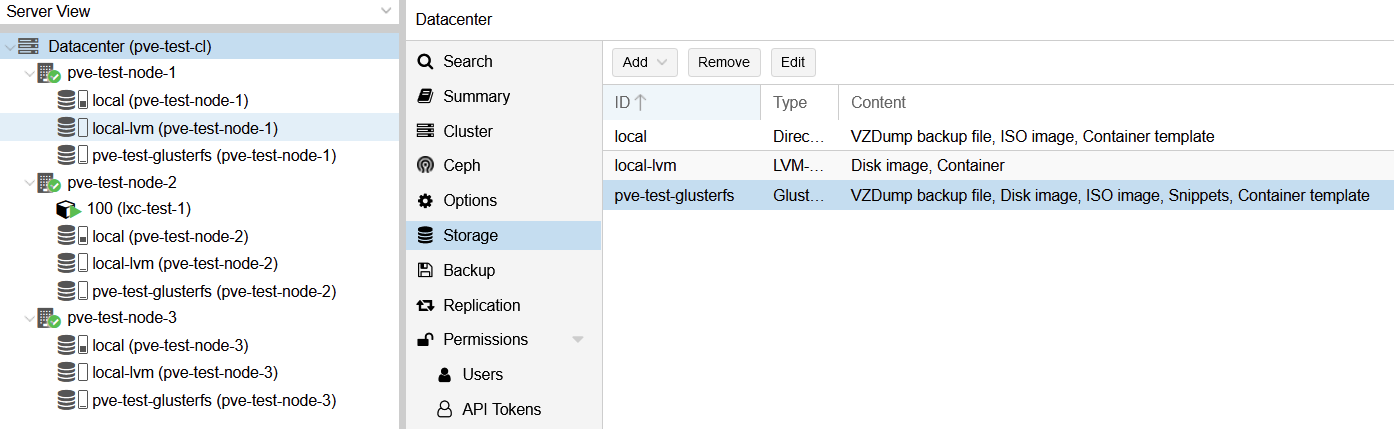

Hab heut Morgen mit meinen 3 VMs mal mit GlusterFS gespielt, installation + config liefen ohne größere hürden. Doku im Anhang.

Aber eine Frage: GlusterFS kann nicht mit LXCs umgehen? Hast du das bei dir gelöst? Wenn ja, wie?

https://forum.proxmox.com/threads/container-on-gluster-volume-not-possible.40889/

-

@darkiop antworte ich dir heute Abend. Da muss ich an en Laptop. Da muss man bissl Tricksen. Und ja mir lxc soll es Performance technisch nicht ideal sein. Ich hatte bisher keine issues damit.

Die drei vms sind jetzt bei dir nicht HA sondern eine vm pro node fest. Gell? Mit Autostart on Boot? Dann könnte das vllt gehen.

Heißt du startest die vms mit dem proxmox node ind definierest das dann als glusterfs Host? Coole Idee. -

@darkiop zur Anleitung ein Feedback: du kann’s es gleich mit replica 3 anlegen. Also muss kein „erst zwei dann Rest“ machen

Aber mach mal noch keine Daten rein!!!! Du brauchst für vm Hosting ein paar spezielle Einstellungen!! Die kannst du mit Daten drin nicht gescheit setzen.

-

@apollon77 sagte in iobroker hochverfügbar:

@darkiop antworte ich dir heute Abend. Da muss ich an en Laptop. Da muss man bissl Tricksen. Und ja mir lxc soll es Performance technisch nicht ideal sein. Ich hatte bisher keine issues damit.

Ok, eilt nicht - auch frühestens heut spät Abend wieder schauen. Performance sollte für zuhause vermutlich trotzdem passen.

Die drei vms sind jetzt bei dir nicht HA sondern eine vm pro node fest. Gell? Mit Autostart on Boot? Dann könnte das vllt gehen.

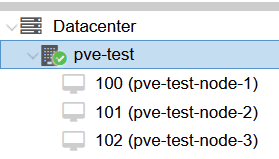

Heißt du startest die vms mit dem proxmox node ind definierest das dann als glusterfs Host? Coole Idee.Die 3 Nodes auf dem Screen sind die 3 VMs mit Proxmox. Innerhalb dieser teste ich dann GlusterFS und Co. Auf pve-test ist Proxmox direkt aufm Blech installiert

@apollon77 sagte in iobroker hochverfügbar:

@darkiop zur Anleitung ein Feedback: du kann’s es gleich mit replica 3 anlegen. Also muss kein „erst zwei dann Rest“ machen

Musste grad eh alles zurücksetzen, teste ich dann beim nächsten mal

Aber mach mal noch keine Daten rein!!!! Du brauchst für vm Hosting ein paar spezielle Einstellungen!! Die kannst du mit Daten drin nicht gescheit setzen.

Ok

-

Ahhh ok hast also IN den VMs auch proxmox und testet da nen proxmox cluser ... auch ne Idee

Also dann ... (kam doch kurz dazu)

- nach aufsetzen des glusterfs volumes noch ein

gluster volume set <VOLNAME> group virtmachen. Das setzt einige Settings sodass sie besser für vms und grössere mages geeignet sind. - prüfen dann mit

gluster volume infoMindestens "features.shard=on" sollte dabei sein ... dann hats geklappt. Sharding heisst das er die echten Files in Chunks von zB nur 64MB aufteilt ... geht dann beim "healing" schneller. Was die anderen Settings alle bedeuten -> https://access.redhat.com/documentation/en-us/red_hat_gluster_storage/3.1/html/administration_guide/chap-managing_red_hat_storage_volumes#Configuring_Volume_Options - Erst dann Daten reinkopieren

Dann empfehle ich "gstatus" als "Monitoring Tool"

- Install: https://github.com/gluster/gstatus#install

- Aufruf überblick nur

gstatus... detailliert `gstatus -a -b´ - Sobald du irgendwas gemacht hast wie updates oder so danach da rein schauen. Vor allem schauen ob Files ein healing machen oder brauchen!

- GlusterFS low level befehl für details

gluster volume status <VOLNAME> detail... so zum merken Da sieht man bei heals noch mehr.

Welche Glusterfs Version hast Du jetzt drauf? Bei proxmox dabei ist ne recht alte. Aktuell ist 9.x ... ich bin auf 8.x ...

-

Vorher Changelog checken! (https://docs.gluster.org/en/latest/release-notes/8.4/)

-

Upgrade Log checken (https://docs.gluster.org/en/latest/Upgrade-Guide/upgrade_to_8/)

-

Proxmox update instructions:

wget -O - https://download.gluster.org/pub/gluster/glusterfs/8/rsa.pub | apt-key add - vi /etc/apt/sources.list.d/gluster.list --> 8 einstellen bzw falls es fehlt halt nochanlegen gluster volume info apt-get update systemctl stop glusterd && systemctl stop glustereventsd && killall glusterfs glusterfsd glusterd glustereventsd apt-get dist-upgrade gluster --version rebootImmer den Proxmx Host nach Update rebooten!

LXC über Proxmox:

- Du hast im proxmox den storage angelegt. Damit mounted proxmox das beim start. mit

mountsiehst Du alles was gerade gemounted ist. Da müsste etwas sein wie "<IP>:<VOLNAME> on /mnt/pve/glusterfs type fuse.glusterfs" - Das jetzt equivalent im /etc/fstab reinschreiben als "<IP>:<VOLNAME> /mnt/pve/glusterfs glusterfs defaults,_netdev 0 0". Wichtig ist das /mnt/pve/glusterfs (oder wie auch immer es bei dir heisst). Merken!!

- achja: Wenn glusterfs lokal ist und auf allen nodes dann am besten in der proxmox konfig einfach "localhost" bei der IP angeben, dann regelt glusterfs das ganze mit connection ... und wenn localhost nicht da ist ist was anderes kaputt.

- In Proxmox dann einen "Directory Storage" anlegen und den lässt Du auf das Glusterfx Mount directory zeigen. in storage.cfg sieht das dann so aus (Mount Dir halt anpassen)

dir: glusterfs-container path /mnt/pve/glusterfs content rootdir is_mountpoint yes shared 1Auf dem Kannst Du dann die Container Images ablegen

Ganz wichtig noch ab glusterfs 8:

systemctl status glusterfssharedstorage.service... wenn es das gibt ... deaktivieren!systemctl disable glusterfssharedstorage.servicesystemctl stop glusterfssharedstorage.servicereboot

Das Funkt sonst beim Reboot dazwischen und unmounted die Directory zu früh wo die LXC noch laufen und dann wird es blöd.

Wenn Du jetzt VMs oder Container auf dem glusterfs hast dann mal starten und mal geflaggt als "HA" oder ohne testen das sie beim Booten sauber automatisch hochkommen und beim reboot sauber beendet werden bevor das glusterfs weg ist. Da hab ich einiges rumgemacht mit.

Am besten /var/log/syslog checken nach bem Reboot das da keine Filesystem fehler angezeigt werden. Beim Boot kann es sein das Proxmox mal sagt "ohh mount noch nicht fertig ... muss noch kurz warten" bevor es die LXC startet. Das ist ok und sollte sich dann paar Sekunden später von selbst geben.Offtopic: Proxmox Cluster: Wenn Du NUCs hast dann nutze den Hardware Watchdog!

In /etc/default/pve-ha-manager WATCHDOG_MODULE=iTCO_wdtDann Reboot und im /var/log/syslog suchen nach wdt um zu schauen obs geklappt hat

Dann viel Spass beim experimentieren und wäre cool am Ende eine Anleitung zu haben :-))

- nach aufsetzen des glusterfs volumes noch ein

-

@darkiop usv bin ich auf den Apc Modellen mit usb Anschluss. Da dann nut dran. Die Usb gehen direkt auf drei meiner proxmox nodes und da will ich später noch ne fancy Steuerung machen weil das mit glusterfs so ein Thema ist (wieder was besonderes dann). Bei nem replika 3 system ist es ja so das dir eine ausfallen darf und noch alles geht. Wenn aber ggf die zweite Maschine (an zweiter usv als Beispiel) auch knapp wird wegen Batterie dann musst du idealerweise ja bevor die runterfährt alles sauber runterfahren. Also dann auch an der dritten usv die an sich noch gehen würde oder gar nicht betroffen ist.

Idee ist also hier zu Monitoren und falls es kritisch wird mittels proxmox Adapter dann alle vms und lxc zu beenden bevor das glusterfs read only geht und wenn wieder zurück ist wieder hochzufahren. Aber das ist noch ne Idee auf nem Zettel.

-

@apollon77 sagte in iobroker hochverfügbar:

Welche Glusterfs Version hast Du jetzt drauf? Bei proxmox dabei ist ne recht alte. Aktuell ist 9.x ... ich bin auf 8.x ...

┬─[root@pve-test-node-1:/tmp]─[15:46:47] ╰─># glusterfs --version glusterfs 5.5Mit Proxmox 6.4 kommt die 5.5 mit

Also da lohtn wohl ein Upgrade auf 8/9

Also da lohtn wohl ein Upgrade auf 8/9

Danke für die vielen Infos. Habe bis inkl. gsatus schon in meine Doku übernommen - ggf. Teste ich das heut Abend noch. Muss jetzt allerdings erstmal los.

@apollon77 sagte in iobroker hochverfügbar:

Dann viel Spass beim experimentieren und wäre cool am Ende eine Anleitung zu haben :-))

Selbstverständlich, ich schreibe Schritt für Schritt mit - da kommt die automatisch bei raus. Ggf. muss man doch noch etwas Hintergrundwissen verlinken / formulieren. Grundsätzlich sollte sich das dann auch auf ein 3-NUC ++ Setup adaptieren lassen.

-

Hallo zusammen, passend zum Thema gibts es hier eine Dokumentation eines kompletten HA Setups: https://forum.iobroker.net/topic/47478/dokumentation-einer-proxmox-iobroker-redis-ha-umgebung

-

Hi

Ich weiß der Thread ist schon alt, jedoch befasse ich mich gerade auch mit dem Thema.

Gibt es mitlerweile was neues oder einen neuen Thread den ich übesehen habe? -

@sufra Ich denke es gibt so 2-3 Threads zum Thema, aber noch keine vollständige Lösung.

Mit Objekten und States im Redis und einem Redis-Multihost setup mit Sentinel im Hintergrund bist Du schonmal unabhängig vom Filesystem.Ich glaube die meisten nutzen aktuell dann eher Proxmox als Cluster mit 2+Quorum oder 3 Nodes mit Shared Filesystem und damit werden beim ausfall eines nodes die VMs bzw container automatisch umverteilt.

Die HA Pläne sind immer noch auf Todo listen, aber bisher gabs immer wichtigere Baustellen.

-

Ich habe mir nun 3 NUCs zugelegt.

Proxmox ist installiert.

Cluster ist erstellt.Nun komme ich bei GlusterFS nicht weiter.

Kann ich hier Fragen dazu stellen oder soll ich einen neuen Thread aufmachen?

Ich habe auch das tolle Tutial von Thorsten und würde mich dann dort auch einbringen wollen. -

@sufra

Auf der iob Seite gibt es eine super Doku.

Mit der kann nichts schief gehen.Bist du nach dieser vorgegangen ?

Wenn nein, warum nicht ?

Wenn ja, an welchem Punkt hakt es da ? -

Zur GlusterFS installation habe ich in der IOBroker Doku nichts gefunden...

Zu IOBroker an sich habe ich auch keine Fragen, habe einen Server schon seit Jahren in Betrieb. -

@sufra sagte in iobroker hochverfügbar:

Zur GlusterFS installation habe ich in der IOBroker Doku nichts gefunden...

gibt es auch nichts, das sprengt den Rahmen, da es mit iobroker nichts zu tun hat

solch Fragen sind dann besser im Proxmox Forum zu stellen