NEWS

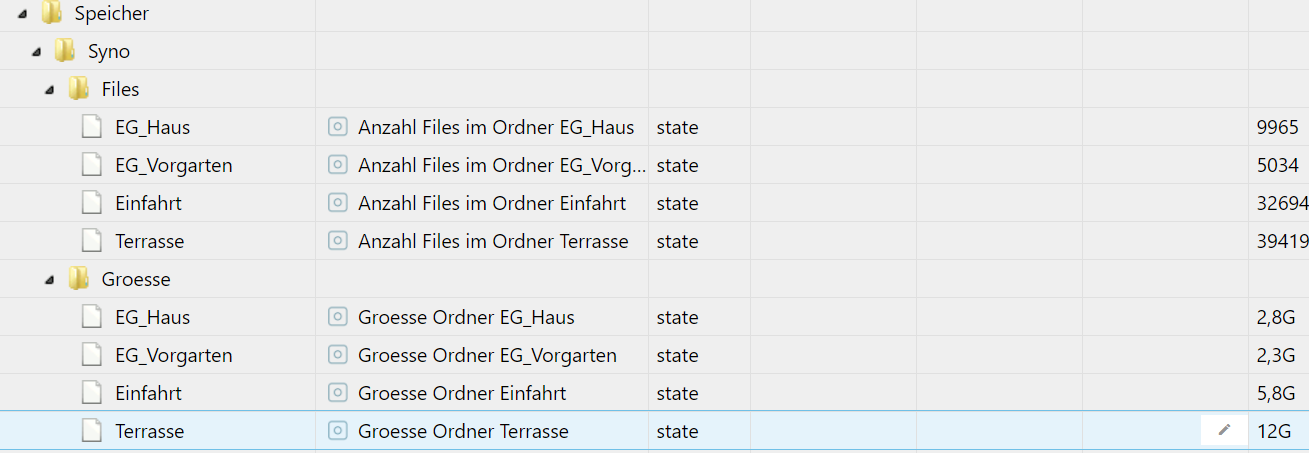

Anzahl Files und dafür belegter Speicherplatz auslesen

-

Wunderbar, der Speicherplatz klappt ja dann ähnlich.

Hast ja da n den ersten "ftp" vom Pfad an dem du dich orientieren kannst, um den Datenpunkt ohne den ganzen Pfad beschreiben zu müssen der da noch mit ausgegeben wird.Den belegten Speicherplatz würde ich auch einzeln auslesen.

Interessant, dass er bei dir die Variablen füllt und bei mir nicht.

-

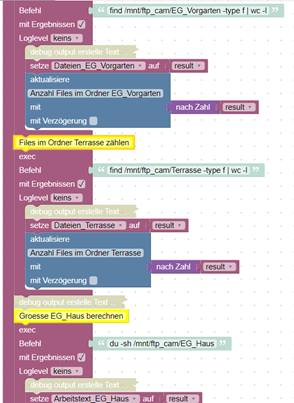

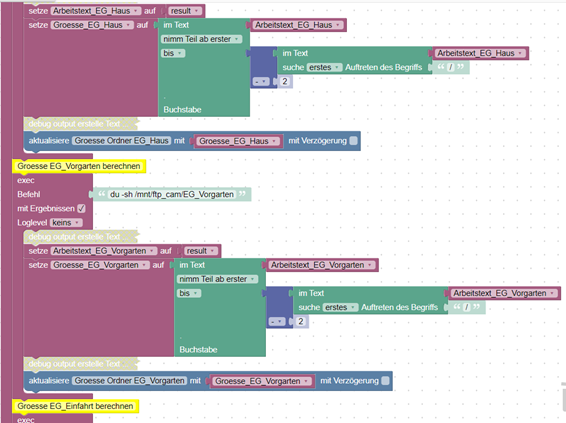

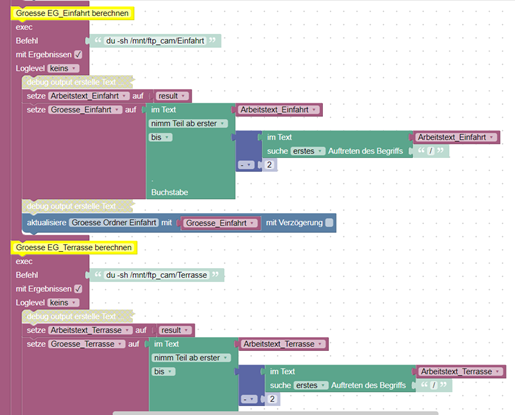

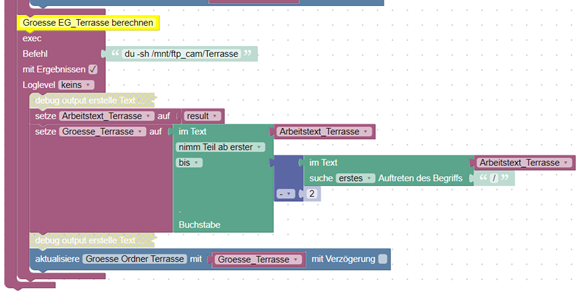

@david-g Ich habe nun das Skript fertig und es strukturiert und zerteilt die Daten schon mal sehr gut. Es gefällt mir nur nicht, dass in meinem Falle 8x in einem Script das Exec Commando genutzt wird. Ich kanns ned festmachen, aber ich denke es ist ned gescheit. Hier mal das aktuelle Skript, ich überlege mir nur schon eine andere Lösung anzugehen.

LG, mxa -

Ka ob das viele exec schadet.

Es gibt ja noch den Adapter Linux control. Evtl kann der sowas. Hab den noch nie getestet. -

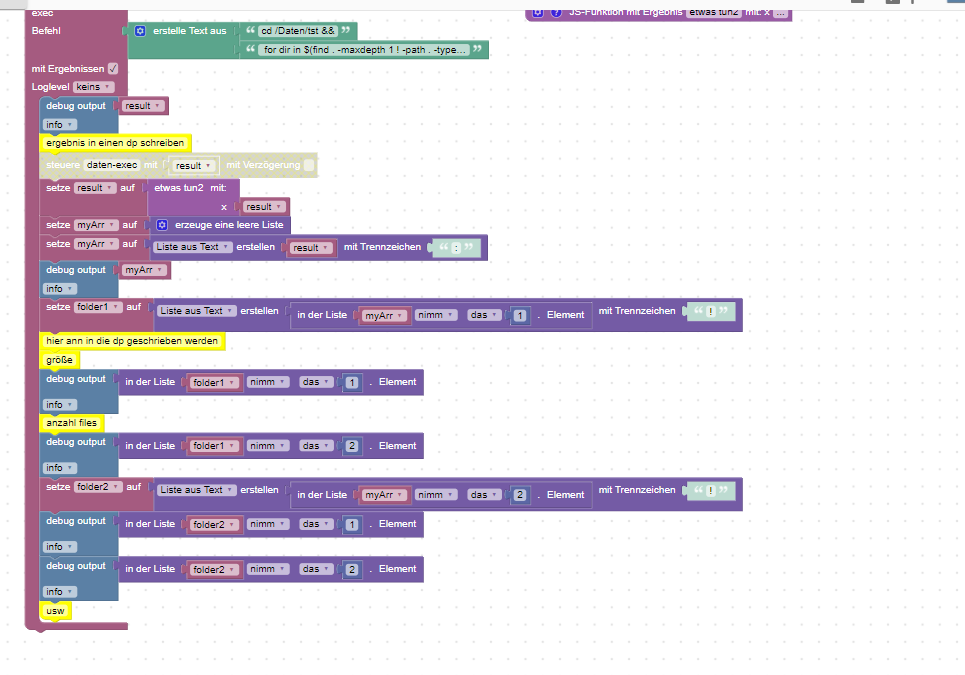

hätte hier mal eine lösung mit einem exec befehl

dazu nutze ich diesen exec befehl

cd /Daten/tst && for dir in $(find . -maxdepth 1 ! -path . -type d | sort); do du -h "$dir" | awk '{print $1}' && echo "!" && find $dir ! -path . | wc -l && echo ":" ; donedanach wird das ganze zerlegt - da sic die ordner nicht ändern und immer den gleichen namen haben, verzichte ich auf die ausgabe des ordner namens

das blockly dazu sieht so aus:

-

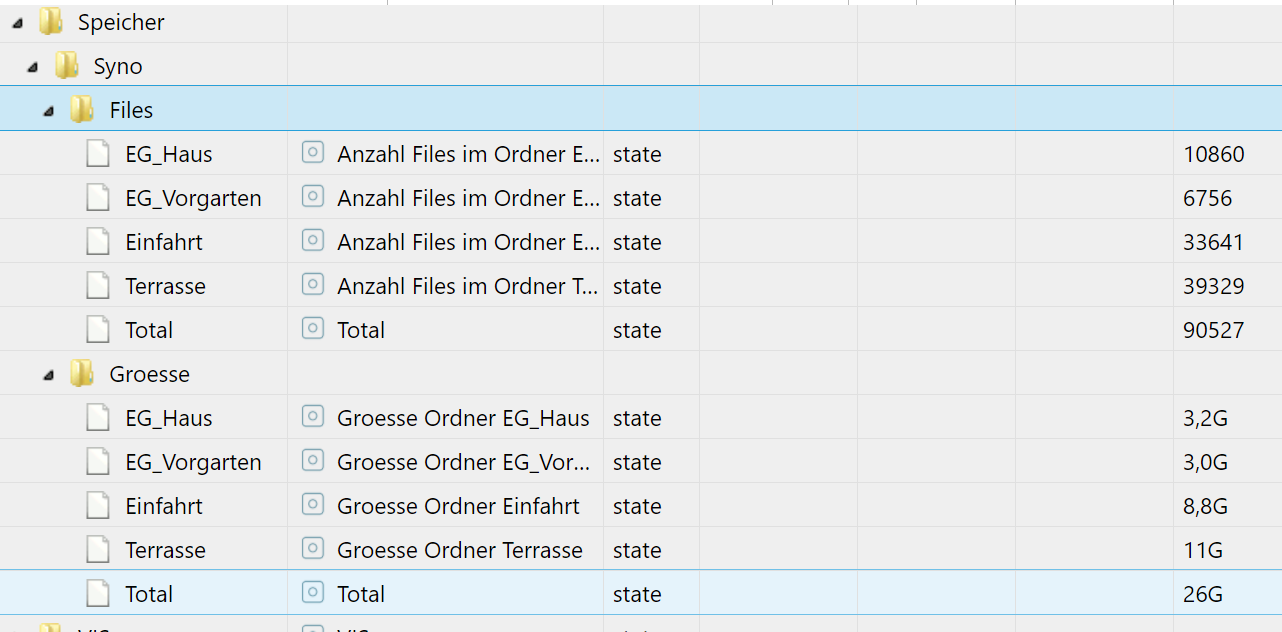

@liv-in-sky Hi und danke! Kannst du mir mal einen Screen hier reinstellen wie die erzeugten DP in der Praxis aussehen?

Lieben Dank -

du kannst deine eigenen d-punkte nehmen (anstatt meinen debugs , schreibst du in deine datenpunkte )- im script muss du nur deinen folder noch im exec eingeben und dann mal im log schauen, was da raus kommt

es kommt immer die größe und dann die anzahl

teste mal ohne datenpunjte zu schreiben und im log erkennst du schon, was da kommt

-

@liv-in-sky sagte in Anzahl Files und dafür belegter Speicherplatz auslesen:

deine datenpunkte

Du hast recht, ein Versuch ist es allemal wert

Wobei, ich bin mit meinem endgültigen Ergebnis auch recht zufrieden, probiere aber deine Herangehensweise natürlich aus.

LG, mxa -

@metaxa nimm das, was dir am besten paßt - eigene scripte , die funktionieren, sind immer besser - selbst gemacht, da kennt man sich aus

edit:

deine dp-struktur bleibt gleich - nur du mußt halt nicht soviele exec ausführen -

@liv-in-sky ich habe jetzt deine Befehlszeile angepasst ausgeführt.

Result:andreas@ioBroker-Prod:~$ cd /mnt/ftp_cam && for dir in $(find . -maxdepth 1 ! -path . -type d | sort); do du -h "$dir" | awk '{print $1}' && echo "!" && find $dir ! -path . | wc -l && echo ":" ; done 3,2G ! 10911 : 3,1G ! 6818 : 6,0G 2,8G 8,8G 8,8G ! 33692 : 5,0G 6,0G 11G 11G ! 39365 :Die Werte die da stehen decken sich da und dort mit den Meinigen, aber nicht alle kann ich wirklich zuordnen.

Weist du eventuell, ob mehrere Execaufrufe - in meinem Skript 8 oder 9 - Probleme verursachen können? Die Prozessorlast in Proxmox bleibt davon unbeeindruckt wenn ich alle Stunden das Script laufen lasse. -

@metaxa Ich denke, dass sollte kein Performance Problem sein

Ich würde vielleicht noch ein&& exitAn jedes der befehlzeilen setzen, damit sicher ist, dass die Verbindungen geschlossen sind

Das& && fügt einfach einen Befehl dazu

-

@metaxa wenn du das

| awk '{print $1}'Aus dem Befehl nimmst, solltest du auch das Verzeichnis in der Konsole sehen

Wegen der ZuOrdnung

Dann funktioniert es aber im Blocky nicht mehr